BERT — это нейронная сеть, созданная Google, доказавшая свои преимущества в ряде задач. С помощью BERT можно создавать программы для обработки естественного языка: анализировать текст, отвечать на произвольные вопросы, создавать переводчики и т.д. В октябре 2019 года компания добавила обученную нейронную сеть BERT в основное ядро алгоритмов Google для английского языка, а в декабре — еще для сотни языков, включая русский. Новое обновление, которое сам Google считает прорывом, получило ожидаемое название BERT. Обновление, по утверждению компании, затронуло 10% всех поисковых запросов.

1. BERT — нейронная сеть от Google

1.1. История развития BERT

Научить машины разбирать и интерпретировать слова, как это делает человек, является интересной и сложнейшей задачей. Над ней с переменным успехом бьются уже не один десяток лет. Ведь в естественном языке крайне много разнообразных нюансов, разобраться в которых с трудом могут даже люди.

В 2018 году состоялся прорыв в NLP (Natural Language Processing). Один за другим выходят ULMFiT, ELMO, OpenAl Transformer, Google BERT. При этом внедрение transfer learning (возможность использовать предварительно обученные модели к практическим данным) позволило активно внедрять NLP для использования в широчайшем круге задач и процессов.

Итак, в 2018 году Google анонсирует BERT (Bidirectional Encoder Representations from Transformers)

BERT использует Transfer learning (трансферное обучение), что позволяет использовать его основную языковую модель, дополнительно обучив её под свои конкретные задачи, самым разнообразным компаниям.

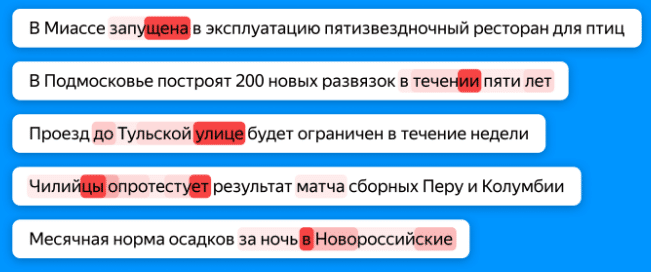

Так, Яндекс, с 2018 года использует BERT в своем переводчике, а с 2019 года — в формировании новостной ленты для оценки «качества» заголовков статей. Алгоритм позволяет находить не только «неправильные» с точки зрения правописания заголовки, но и устаревшие новости. Перед этим Яндекс обучил BERT поиску опечаток и рассогласований слов с помощью собственных асессоров из Толоки.

В августе 2019 года вышла улучшенная версия BERT под именем RoBERTa, где исследователи из Facebook и Вашингтонского университета увеличили количество данных для претренинга, длину входящих последовательностей и время обучения. При этом они удалили задачу по «предсказанию следующего предложения», которая изначально была в BERT и отрицательно влияла на результаты и усложнили задачу с маскировкой отдельных слов.

На данный момент существует еще одна новая версия BERT — ALBERT (аббревиатура от «lite BERT», то есть, «облегчённый BERT»), c немного измененной базовой структурой нейросети и показывающая лучшие результаты в тестах GLUE.

1.2. Как работает нейросеть BERT

Основная проблема современных задач обработки естественного языка (NLP) — найти достаточно размеченных людьми примеров, чтобы обучить нейросеть. Если нужен рост качества, то обучающая выборка должна быть очень большой — миллионы и миллиарды примеров. При этом задач в NLP много и все они разные. Собрать данные в подобных объёмах под каждую задачу долго, дорого, а зачастую и невозможно.

Но есть вариант обойти эту проблему — с помощью обучения в два этапа. Сначала долго и дорого на огромном корпусе в миллиарды слов нейросеть учат структуре языка (это pre-training). Потом сеть быстро и дёшево подкручивают под конкретную задачу — например, для разделения отзывов на плохие и хорошие (это fine-tuning).

До 2018 года одним из основных инструментов претренинга было нечто вроде словаря. Этот словарь использовал векторное представление слов (word embedding), описывавших связи между словами в виде цифр так, чтобы нейросети могли воспринимать эту информацию, как входные данные. Однако прошедшая претренинг на векторном словаре нейросеть всё равно оставалась слепой к смыслу слов на уровне предложений. С её точки зрения, предложения «человек укусил собаку» и «собака укусила человека» идентичны.

Улучшенный метод использует претренинг для обеспечения нейросети более богатыми правилами – не только словарём, но и синтаксисом с контекстом – перед тем, как обучать её на выполнение определённой задачи по NLP. Вместо претренинга только одного, первого слоя сети при помощи векторного представления слов, исследователи начали обучать нейросети целиком на более общей задаче под названием языковое моделирование. Такие языковые модели с глубоким претренингом можно довольно эффективно создавать. Исследователи просто скармливают своим нейросетям огромные объёмы написанного текста из свободных ресурсов вроде Википедии – миллиарды слов, расставленных в грамматически корректные предложения – и дают сети возможность предсказывать следующее слово самостоятельно. Более того, такие предварительно обученные нейросети могут применять свои репрезентации языка для обучения более узкой задаче, не связанной с предсказанием слов – к процессу тонкой настройки.

На этой идее и основана технология BERT (Bidirectional Encoder Representations from Transformers).

По сути, BERT состоит из трех важнейших составляющих. Во-первых — это прошедшая претренинг языковая модель. Во-вторых – возможность решить, какие из особенностей предложения являются наиболее важными.

Transformer — это такая архитектура нейросети, которая позволяет учитывать весь контекст сразу. Непоследовательная природа трансформера представляет предложения более выразительно (древовидно). Каждый слой нейросети устанавливает много параллельных связей между определёнными словами, игнорируя остальные.

Такие древовидные репрезентации предложений дают трансформерам возможность моделировать контекстный смысл, а также эффективно изучать связи между словами, стоящими далеко друг от друга в сложных предложениях.

В-третьих, в отличие от других прошедших претренинг языковых моделей, созданных посредством обработки нейросетями терабайтов текста, читаемого слева направо, модель BERT читает и справа налево, и одновременно слева направо, и обучается предсказывать, какие слова случайным образом были исключены из предложений.

К примеру, BERT может принять на вход предложение вида «Джордж буш […] в Коннектикуте в 1946 году», и предсказать, какое именно слово скрыто в середине предложения (в данном случае, «родился»), обработав текст в обоих направлениях. Эта двунаправленность заставляет нейросеть извлечь как можно больше информации из любого подмножества слов.

Используемый BERT претренинг, похожий на игру в слова – языковое моделирование с маскированием – вещь не новая. Его десятилетиями использовали для оценки понимания языка людьми. Для Google он обеспечил практический способ использования двунаправленности в нейросетях вместо односторонних методов претренинга, доминировавших в этой области до этого.

Каждый из трёх этих составляющих – глубокая модель языка с претренингом, внимание и двунаправленность – существовали до BERT по отдельности. Но до тех пор, пока Google не выпустил свой алгоритм в конце 2018 года, никто не скомбинировал их таким успешным образом.

2.Внедрение BERT в основной алгоритм поиска Google

2.1. BERT — новое обновление ядра алгоритмов Google

В октябре 2019 года Google «выкатил» обновление ядра алгоритмов поиска под названием BERT. Отныне, одноименная нейросеть будет работать в качестве составляющего ядра алгоритмов поиска. По заверению Google — это крупнейшее обновление ядра со времен RankBrain.

Многие вебмастера не заметили скачков трафика после внедрения нового алгоритма, хотя Google заверяет, что оно коснулось 10% всех поисковых запросов. Чтобы понять, почему вебмастера не ощутили значительных колебаний трафика, еще раз рассмотрим как работает BERT и на какие запросы он влияет.

BERT хорошо работает на длинных запросах. Он позволяет предсказывать пропущенные в запросе слова, лучше «понимает» саму структуру запроса и выдает более релевантные результаты в органической выдаче и в «расширенных фрагментах». Таким образом, BERT лучше понимает НЧ и микро-НЧ запросы, длинный хвост запросов. В частности это могут подтвердить дорвейщики, которые ощутили резкие колебания трафика и некоторые вебмастера, плотно работающие с 3-5 словниками, что характерно для продуктовых партнерок, например работающих под Amazon.

Типичный вебмастер, в основном, сфокусирован на СЧ или даже ВЧ запросы, которые достаточно коротки (1-3 слово), поэтому они просто не замечают колебания, которое оказал BERT на выдачу.

Существенное влияние нейросеть окажет на голосовые запросы. Они, как правило, гораздо длинней и теперь ядро поиска Google сможет более точно и полно ответить на запрос.

Так же, необходимо понимать, что BERT это не изолированный фактор ранжирования, нейросеть напрямую не влияет на ранжирование в органике. Google научился немного лучше распознавать запрос, но непосредственно на ранжирование влияют сотни факторов и тысячи их комбинаций.

Однако, если вы не заметили значительных флуктуаций в выдаче, это не означает, что их не было. Вы просто их не искали.

2.2.Как найти запросы, на которые повлиял BERT

Методика поиска таких запросов стандартна и я её описывал неоднократно за последние несколько лет, например в статье про YMYL в разделе «Как найти некачественный контент на сайте».

Для поиска запросов, на которые оказал влияние BERT можно использовать Google Analytics. Даты релиза алгоритма нам известны — 21 октября 2019 для англоязычных и 9 декабря для русскоязычных сайтов. Отсчитываем 4 недели после даты релиза (можно и больше) и сравниваем его с предыдущим периодом.

Используем каналы (органическую выдачу Google). И строим разрез по ключевым словам.

Нам интересны именно длинные запросы (НЧ) и те, которые существовали в предыдущем периоде, а в новом периоде (после внедрения алгоритма) не имеют показов. Так мы найдем утерянные запросы.

Отсортировав результат по отсутствующим в предыдущем периоде и появившемся в новом (после релиза ядра алгоритмов), мы увидим, какие запросы появились, как теперь Google осмысляет контент.

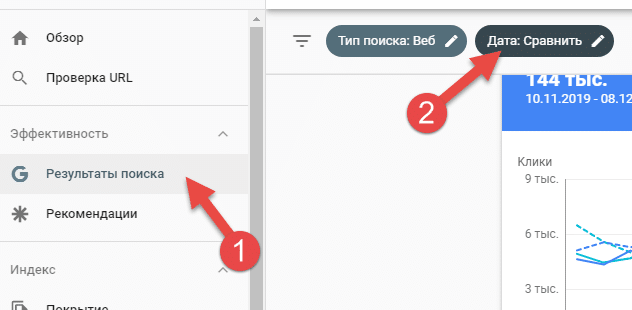

Особым эстетам, все то же самое можно проделать в Google Search Console. Выбираем «Эффективность» — «Результаты поиска» (1) и устанавливаем диапазоны дат (2).

Мы должны получить четкое представление о запросах, у которых было 0 показов до BERT, а теперь этот запрос ранжируется (показывается в выдаче) или о тех запросах, которые перестали показываться после обновления BERT.

Здесь, мы выбираем закладку «Сравнить» (1), выбираем «Пользовательский» диапазон дат (2).

Так как сайт русскоязычный, то дата обновления ядра — 9 декабря 2019 года. Выставляем 4 недели до этой даты (3) и 4 недели после этой даты (4).

Помните, что это обновление в значительной степени затронуло семантические запросы с длинным хвостом, которые, по своей сути, являются микро-НЧ с минимальным объемом поиска. Поэтому вам необходимо выбрать самые широкие диапазоны дат, которые вы сможете. Обратите внимание, чтобы в этот диапазон не попадали значительные обновления контента на сайте, которые могут смазать картину.

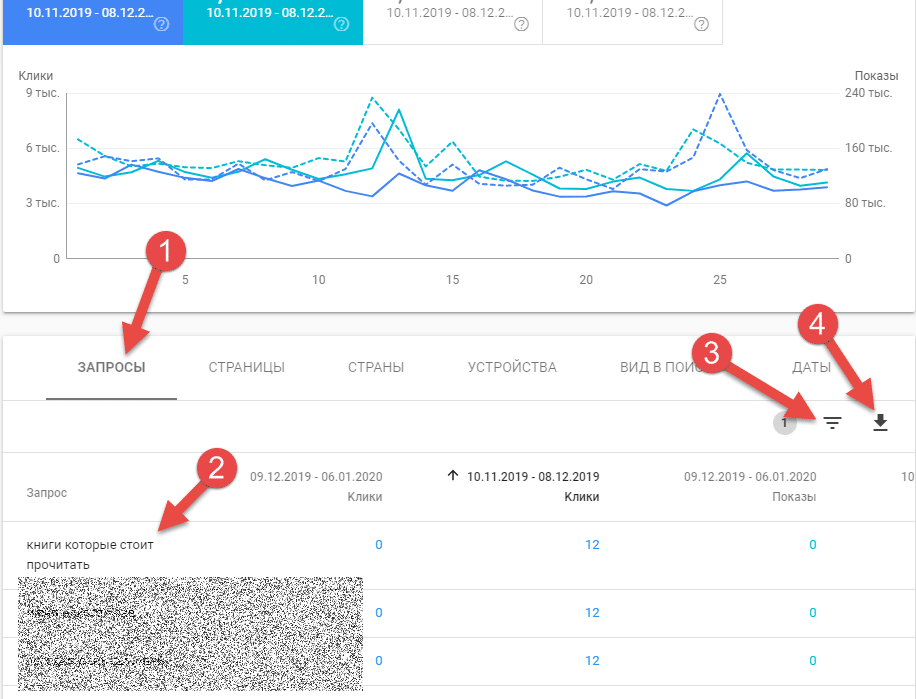

Получаем результаты по выбранным диапазонам дат. Во вкладке «Запросы» (1) мы видим непосредственно список запросов (2). Мы их можем отфильтровать, например по «пропавшим» запросам (3) или выгрузить для анализа в Excel (4).

Не забываем отсортировать или отфильтровать запросы по показам равным 0 в одном из периодах.

Если не было значительных обновлений контента сайта за этот период, то с большой долей уверенности можно сказать, что на эти запросы оказал влияние BERT — обновление ядра алгоритмов Google.

2.3. Как оптимизировать сайт под BERT

Сотрудники Google утверждают, что оптимизация под BERT — невозможна.

Так, Дэнни Салливан высказался, что «нет ничего, что можно оптимизировать для BERT». В январе 2019 года Джон Мюллер рассказал чуть объемней о б оптимизации сайтов под алгоритм BERT.

Смотрите с тайм кода 18:32.

Мюллер сообщил, что с помощью BERT Google пытается лучше понять текст.

«С одной стороны, запуск BERT дает нам лучшее понимание вопросов и запросов, которые задают пользователи. С другой стороны, алгоритм позволяет нам лучше понять текст на странице».

«Запросы не являются чем-то, на что вы можете повлиять в плане SEO», – сообщил Мюллер.

Затем он дал несколько советов, как работать с текстовым контентом: «Текст на странице – это то, на что вы можете повлиять. Наша рекомендация по сути сводится к следующему: пишите естественно. Большинство алгоритмов пытаются понять естественный текст, а также понять, каким темам посвящена эта страница, чтобы найти наилучшее соответствие запросу».

«Если есть что-то, что вы можете сделать для оптимизации под алгоритм BERT, так это убедиться, что на ваших страницах естественный текст… Вместо того, чтобы использовать как можно больше ключевых слов, пишите естественно».

Не густо, не правда-ли? И как всегда, сотрудники Google лукавят, что ничего сделать нельзя. Но необходимо сделать два важных уточнения.

Во-первых, необходимо помнить, что результаты работы BERT призваны повысить эффективность поиска прежде всего по «непопулярным» низкочастотным запросам и используется для формирования «нулевой» выдачи — когда Google не может найти релевантные сайты и выводит наиболее близкие к запросу результаты.

Во-вторых, BERT затрагивает, в основном, информационные запросы, и в меньшей мере транзакционные и навигационные запросы.

Google приводит примером результаты выдачи по запросу «Может ли преподаватель выгнать студента с занятия?». Старый алгоритм давал ответ на вопрос «Имеет ли преподаватель право не пустить студента на пару?», что имеет абсолютно иной смысл. Сейчас BERT обрабатывает фразу пользователя более правильно, помещая на первую строку самый подходящий контент. Еще больше примеров есть в статье про BERT от Google.

Итак, чтобы «оптимизировать» под алгоритм BERT, рекомендую изучить ваш набор данных по приобретенным и потерянным ключевым словам и провести традиционную оптимизацию контента, чтобы улучшить или восстановить позиции запросов.

Сначала вам нужно определить ключевые слова, которые вы потеряли после обновления BERT и заняться редакцией контента для их восстановления. При этом вовсе не нужно добавлять в контент эти поисковые запросы. Иногда достаточно добавить несколько предлогов и перефразировать пару предложений.

В случае «пропажи» запросов, скорее всего страница перестала ранжироваться из-за «смещения акцентов» в смысле контента, совсем как в примере про преподавателя и студента. Обновление BERT помогает Google лучше понимать семантику (значение слов и фраз). Это означает, что если вы ранее ранжировались по фразе с длинным хвостом, но потеряли позиции после внедрения BERT, то, вероятно, страница соответствовала ключевым словам в запросе, но на самом деле не соответствовала цели поиска (интенту). Необходимо добавить смысла тем фразам и акцентировать внимание на тех словах, которые соответствуют интенту пользователя.

Улучшайте ваш контент и для тех ключей, которые появились после обновления BERT. Изучите, что именно пишут конкуренты и как они расставляют акценты в своих текстах. Используйте идеи конкурентов, чтобы сделать свой контент более «ценным», чем у них. Необходимо отвечать на конкретные запросы в своем контенте лучше, чем конкуренты.

Если на сайте есть инфографика, слайды, видео или аудио — записи, то сделайте их текстовую расшифровку.

Интересное наблюдение сделал Manish Dudharejia в статье на SearchEngineJournal.com. Он отметил, что для BERT объем контента не играет значительной роли. Прекрасно ранжируется контент размером в несколько сот символов, однако при условии, что он отвечает на заданный вопрос пользователя. Действительно, НЧ запросы — крайне конкретны. Они подразумевают четкий и лаконичный ответ, в отличии от многих СЧ или ВЧ запросов. Именно поэтому точность ответа становиться более важным фактором, чем объем контента или точное вхождение ключа в контент.

Хороший рост показали информационные сайты, построенные по SILO-структуре. Здесь изолированные кластеры запросов более точно давали ответы на НЧ запросы за счет наличия значительного числа «поддерживающих» страниц.

Заключение

Внедрение нейросети BERT в ядро алгоритмов поиска Google — очередной шаг корпорации к улучшению понимания запросов пользователей, заданных на естественном языке.

Нейросеть будет развиваться на всех уровнях. Уверен, что она пройдет не только post но pre- тренинг, будет постоянно обучаться, в том числе и силами асессоров, контролирующих качество органической выдачи. Все это скажется в дальнейшем на стратегиях продвижения сайтов и способах манипуляции ранжирующими факторами.

И обратите внимание, что русскоязычная языковая модель, по сравнению с англоязычной, на порядок хуже прошла пре-тренинг и показывает гораздо худшие результаты. Это означает, что основные обновления как языковой модели, так и обученной нейросети BERT еще впереди.

Готовьтесь и читайте правильную литературу, чтобы понимать, как нужно оптимизировать свой сайт.

Будьте здоровы!

- Нажмите, чтобы открыть список литературы

- Гаскаров Т. Как Яндекс научил искусственный интеллект находить ошибки в новостях / Т. Гаскаров – Текст: электронный // Habr: Интернет-портал. – URL: https://habr.com/ru/company/yandex/blog/479662/ (дата обращения: 15.01.2020)

- Голованов В. Машины уже опережают людей в тестах на чтение; но понимают ли они прочитанное? / В. Голованов – Текст: электронный // Habr: Интернет-портал. – URL: https://habr.com/ru/post/479446/ (дата обращения: 15.01.2020)

- DesertFlow. BERT — state-of-the-art языковая модель для 104 языков. Туториал по запуску BERT локально и на Google Colab / DesertFlow – Текст: электронный // Habr: Интернет-портал. – URL: https://habr.com/ru/post/436878/ (дата обращения: 16.01.2020)

- Nayak P. Understanding searches better than ever before / Pandu Nayak – Текст: электронный // Google Blog: Интернет-портал. – URL: https://blog.google/products/search/search-language-understanding-bert (дата обращения: 14.01.2020)

- Dudharejia M. How Will Google BERT Impact Your Content Strategy? / Manish Dudharejia — Текст: электронный // Search Engine Journal: Интернет-портал. – URL: https://www.searchenginejournal.com/google-bert-content-strategy/336377 (дата обращения: 14.01.2020)

- Devlin J. Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing //Jacob Devlin, Ming-Wei Chang — Текст: электронный // Google AI Blog: Интернет-портал. – URL: https://ai.googleblog.com/2018/11/open-sourcing-bert-state-of-art-pre.html (дата обращения: 14.01.2020)

Янв

2020

Об авторе:

DrMax. Занимаюсь аудитами, оценкой качества YMYL проектов и SEO сайтов более 20 лет. В настоящее время провожу аудиты и реанимирую трафик сайтов, восстанавливаю позиции в органической выдаче сайтов, помогаю снять алгоритмические и ручные штрафы Google. В портфолио - продвижение несколько десятков проектов как региональных частников, так и крупнейших мировых компаний. Владелец SEO блога Drmax.su. Автор 22 книг по продвижению и аудиту сайтов.